L’avvento di una Super-Intelligenza Artificiale è prossimo e da esso dipenderanno le sorti del genere umano. Ma ne siamo davvero consapevoli?

Un contributo per riflettere di Maurizio Lotito dal sito Medium

Mi sono imbattuto in una classica lettura illuminante, di quelle che lasciano un segno indelebile capace di condizionare profondamente la visione della vita e del futuro. È anche la molla che da tempo desideravo scattasse per inaugurare la mia presenza su Medium. Ed eccomi finalmente qui.

Ammetto che l’esordio scelto è alquanto masochista. Ciò di cui scriverò infatti, non è soltanto un argomento importante. È probabilmente l’argomento PIÙ importante che possa riguardare il futuro di noi tutti.

Il tutto nasce dalla lettura di due lunghissimi articoli scritti da Tim Urban, autore del blog WaitButWhy.com. Quanto segue è la mia personalissima sintesi (parola grossa, ve ne accorgerete) ed adattamento, invito quindi i più appassionati ed esperti dell’argomento a consultare il testo originale.

“Siamo sull’orlo di un cambiamento paragonabile alla nascita della vita umana sulla Terra.”

Qualcosa tipo raggiungere l’immortalità o tutte le meraviglie che il nostro cervello può concepire – nello scenario più ottimistico. O causare l’estinzionedell’intero genere umano, in quello peggiore. E questo grazie alla creazione di un’entità il cui potere è paragonabile, almeno per la nostra attuale comprensione, a quello di un Dio.

AI: Artificial Intelligence

Chiariamo subito: quello di cui parleremo non è fantascienza o il delirio di qualche eccentrico visionario. È quello in cui moltissimi scienziati e pensatori — i più intelligenti, brillanti e consapevoli — credono fermamente. È quello su cui le startup e le aziende più innovative del pianeta stanno lavorando e che attrae miliardi di dollari di investimenti. E se semplicemente si guarda alla storia passata, è ciò che tutti noi dovremmo logicamente aspettarci per il futuro.

Cominciamo prima col definire cosa intendiamo per Intelligenza. La professoressa Linda Gottfredson la descrive così:

“Una capacità mentale generale, che, tra l’altro, comporta la capacità di ragionare, pianificare, risolvere problemi, pensare in maniera astratta, comprendere idee complesse, imparare in fretta e imparare dall’esperienza.

Molto più confusa e distorta è la percezione di cosa sia l’Intelligenza Artificiale, in particolare per tre ragioni:

- L’AI viene associata ai film. 2001 Odissea nello Spazio. Terminator. Matrix.E dato che i film sono fiction, anche l’AI finisce per sembrare un frutto della fantasia;

- L’AI è un argomento vastissimo. Spazia dal computer di uno smartphone all’auto che si guida da sola, fino ad arrivare a qualcosa che in futuro potrebbe cambiare il mondo in modo drammatico. L’AI si riferisce a tutte queste cose, il che è ulteriore fonte di confusione.

- Usiamo l’AI quotidianamente, ma spesso neanche lo sappiamo. John McCarthy, che ha coniato il termine “Intelligenza Artificiale” nel 1956, ha affermato che “non appena funzionerà, nessuno la chiamerà più AI”. Per questo l’AI suona spesso come una previsione futuristica, piuttosto che una realtà di tutti i giorni.

Inoltre, l’AI non va confusa con i robot. Un robot è un semplice contenitore, la vera AI è il computer che lo governa. Alcuni robot cercano di mimare la forma umana, altri no, in ogni caso se il robot è il corpo, l’AI è il cervello.

Come già detto l’AI è un topic vastissimo, ma possiamo circoscrivere il campo definendone i tre principali livelli:

1) Artificial Narrow Intelligence (ANI) — Intelligenza Artificiale Ristretta, ovvero specializzata in uno specifico compito. Questa AI può ad esempio battere il campione mondiale di scacchi, ma è l’unica cosa che sa fare. Se gli chiedete di trovare un modo migliore per memorizzare i dati su un disco rigido, vi guarderà senza capire.

2) Artificial General Intelligence (AGI) — Intelligenza Artificiale Generale, a volte indicata come AI forte, o di livello umano, si riferisce ad un computer che sia intelligente quanto un essere umano ed in grado di eseguire qualsiasi compito intellettuale con la nostra stessa facilità. La creazione dell’AGI è però un compito molto più complesso che creare l’ANI, ed infatti ci stiamo ancora lavorando.

3) Artificial Superintelligence (ASI) — Superintelligenza Artificiale. Nick Bostrom definisce la Superintelligenza Artificiale “un intelletto molto più intelligente dei migliori cervelli umani, in ogni campo, inclusa la creatività scientifica, la saggezza generale e le abilità sociali.” La Superintelligenza va da un computer che è solo un po’ più intelligente di un essere umano ad uno che è trilioni di volte più intelligente, in ogni campo. L’ASI è il motivo che rende il dibattito sull’AI così scottante, ed è anche il motivo per cui parole come immortalità, estinzione e Dio appariranno più volte in questo post.

A che punto siamo

Non molti se ne accorgono, ma viviamo già in un mondo che funziona grazie all’ANI (un’intelligenza artificiale uguale o superiore a quella umana nell’eseguire un compito molto specifico). Qualche esempio:

- Le auto sono pieni di sistemi ANI, dal computer che attiva l’antibloccaggio dei freni a quello che regola il sistema di iniezione. L’auto di Google che si guida da sola contiene i sistemi ANI più evoluti in questo campo.

- Lo smartphone è una piccola fabbrica di ANI. Quando si naviga utilizzando l’applicazione Mappe, quando si ricevono consigli personalizzati da Spotify, Facebook, Amazon, etc., quando si parla con Siri ed in altre decine di utilizzi quotidiani, si utilizza l’ANI.

- Il filtro anti-spam delle e-mail spam è un classico tipo di ANI programmato per capire cosa è spam e cosa non lo è, impara e orienta la propria intelligenza sulle vostre preferenze particolari. Il termostato Nest fa la stessa cosa, analizza la vostra tipica routine ed agisce di conseguenza.

- Google Translate è un altro impressionante esempio di un classico sistema ANI bravo in un compito ristretto. Il riconoscimento vocale è un altro e ci sono un sacco di applicazioni che utilizzano queste due ANI congiuntamente per ottenere traduzioni vocale in tempo quasi reale.

- Quando un aereo atterra, non è un essere umano che decide dove e quando farlo. Proprio come non è un essere umano a determinare il prezzo del biglietto per quel volo.

- I migliori giocatori al mondo di dama, scacchi, Scrabble, Backgammon e Otello sono oggi tutti sistemi ANI.

- Il motore di ricerca Google è un enorme cervello ANI, che utilizza metodi incredibilmente sofisticati per determinare il ranking delle pagine e capire cosa mostrare in particolare. Lo stesso vale per il News Feed di Facebook.

E questo, solo nel mondo consumer. Sistemi sofisticati di ANI sono ampiamente utilizzati nel settore militare, nell’industria e nella finanza (più della metà delle azioni di capitale negoziate nel mercato USA sono governate da algoritmi ANI), in sistemi esperti che aiutano i medici a fare le diagnosi, per finire al famoso Watson di IBM, che ha partecipato a tre episodi del quiz televisivo Jeopardy!, sconfiggendo i suoi avversari umani nell’unico scontro uomo-macchina della storia dello show.

Appurato quindi che il nostro mondo è sempre più dipendente dall’utilizzo di sistemi ANI, a quali rischi ci espone concretamente questa condizione?

Nella peggiore delle ipotesi, un ANI mal-programmato potrebbe disattivare un’intera rete elettrica, causare un malfunzionamento in una centrale nucleare, o innescare un disastro finanziario. Ma, per quanto catastrofici, i rischi a cui ci espone l’ANI sarebbero comunque circoscritti, ancora lontani dal costituire una minaccia esistenziale per il genere umano. Eppure dovremmo guardare a questo sempre più grande e complesso ecosistema di ANI relativamente innocue come il precursore di un uragano in arrivo, in grado di alterare per sempre il nostro mondo. Ogni nuova innovazione ANI aggiunge silenziosamente un altro mattone alla strada per raggiungere l’AGI e l’ASI.

«Il futuro non è più quello di una volta»

L’aspetto più interessante dell’intera faccenda è che questo cammino potrebbe concludersi molto presto. I più ottimisti — come, Ray Kurzweil, uno dei massimi esperti di AI e pionere del settore — dicono tra il 2029 ed il 2045, mentre in un sondaggio sottoposto a centinaia di esperti mondiali di AI, la media delle previsioni concorda nella possibilità di raggiungere l’AGI nel 2040 e l’ASI nel 2060.

Quindi nell’arco della vita della maggior parte di coloro che stanno leggendo questo post.

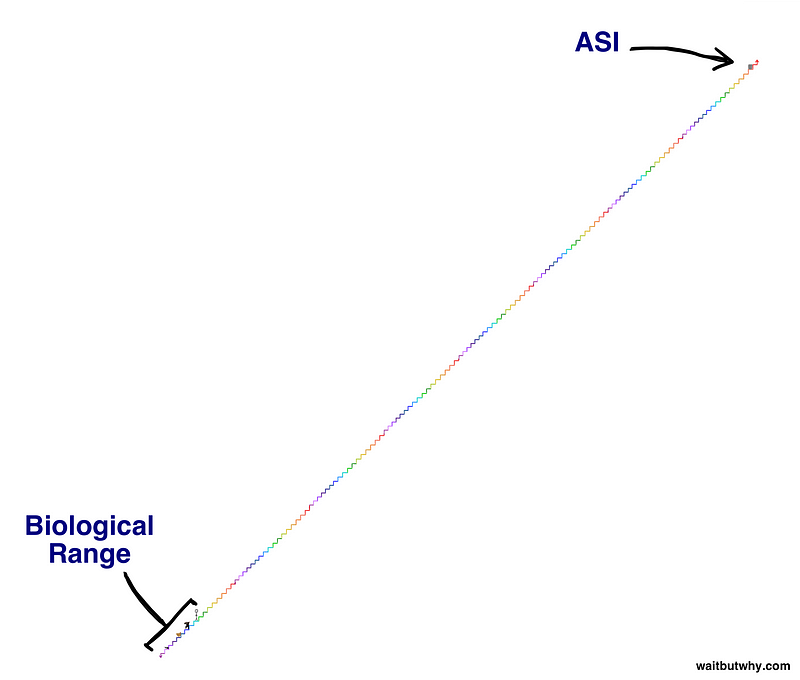

Adesso date un’occhiata a questa immagine ed immedesimatevi nell’omino:

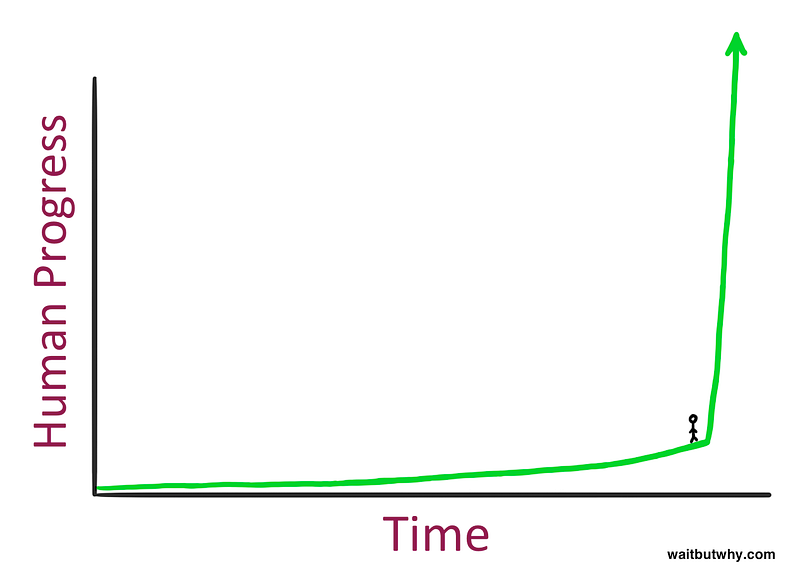

Abbastanza normale e familiare vero? Il problema è che quando si sta in piedi su una linea temporale non ci è dato di sapere cosa c’è alla nostra destra:

Come vi sentite adesso? Sembra un punto molto più interessante su cui trovarsi…

[ Questo è il momento in cui molti di voi stanno pensando: “figo, ma… naaaaah, non può succedere, o almeno non così presto” ]

Immaginate di prendere una macchina del tempo e di tornare indietro nel 1750 per scegliere una persona qualunque, portarla nel 2015, passeggiare con lei ed osservare la sua reazione generale.

Pensate a cosa potrebbe provare nel vedere gente all’interno di strane capsule luccicanti correre su un’autostrada, nell’ascoltare una performance musicale avvenuta cinquant’anni prima, nel giocare con un magico rettangolo che puoi usare per catturare immagini o momenti di vita reale, nel seguire una mappa con un puntino blu animato che mostra il luogo preciso in cui ti trovi, nel guardare in faccia e parlare a qualcuno che si trova dall’altra parte dell’oceano. E questo ancor prima di spiegargli cosa sia Internet, la Stazione Spaziale Internazionale, il Large Hadron Collider, un’arma nucleare o la relatività generale. Per convenzione, descriveremo un’esperienza così al limite come uno shock esperienziale.

Adesso immaginate che egli torni indietro nel 1750 ed utilizzando la macchina del tempo decida di far provare la stessa esperienza ad un tizio del 1500. Quest’ultimo certamente rimarrebbe impressionato da un sacco di cose ma non quanto il tizio del 1750 perché le differenze tra il 1500 e il 1750 sono molto inferiori a quelle del 1750–2015. Avrebbe imparato qualche nuovo concetto sullo spazio e sulla fisica, visto nascere l’imperialismo in Europa, rivisto la sua concezione geografica del mondo. Ma guardando alla vita di tutti i giorni (trasporti, comunicazioni, eccetera), non ne rimarrebbe certamente così scioccato. Per replicare una tale esperienza, bisognerebbe tornare al 12.000 avanti Cristo, prima che la Rivoluzione Agricola desse origine alle prime città ed al concetto di civiltà, e mostrare ad un semplice cacciatore-raccoglitore — quasi alla pari di altre specie animali — i vasti imperi del 1750, le imponenti chiese, le navi capaci di attraversare gli oceani, l’enorme quantità di conoscenza e di scoperte accumulatesi.

Ed ancora, per riprodurre la stessa esperienza bisognerebbe tornare indietro almeno di 100.000 anni e trovare qualcuno a cui mostrare l’addomesticamento del fuoco e l’invenzione della prima forma di linguaggio.

- Ci sono voluti 100.000 anni per raggiungere il primo livello di shock esperienzale (era della caccia)

- 12.000 anni per il secondo (rivoluzione post-agricola)

- circa 200 anni per il terzo (rivoluzione post-industriale).

Questo modello — il progresso umano che diventa sempre più veloce col passare del tempo — è quello che Ray Kurzweil ha utilizzato per enunciare la Legge dei Ritorni Acceleranti (Law of Accelerating Returns). Accade cioè che le società più avanzate hanno la capacità di progredire ad un ritmo più veloce di quelle meno evolute. L’umanità del XIX secolo sapeva molto di più e disponeva di una migliore tecnologia dell’umanità del XV secolo, non deve quindi soprendere che ci siano stati molti più progressi nel XIX secolo che nel XV. La storia ci dimostra quindi che i progressi sono sempre più grandi ed avvengono sempre più velocemente.

Kurzweil ha calcolato che il progresso di tutto il XX secolo sia stato raggiunto in soli 20 anni al tasso di avanzamento del 2000. In altre parole, nel 2000, il tasso di progresso era cinque volte più veloce rispetto al tasso medio di progresso di tutto il XX secolo. Dopo il 2000 ci sono voluti soli 14 anni per eguagliare l’intero progresso del XX secolo e Kurzweil prevede che ci vorranno solo 7 anni per eguagliarlo nuovamente (nel 2021). Un paio di decenni più tardi accadrà più volte nello stesso anno, e poi in meno di un mese. Tirate le somme, in virtù della Legge dei Ritorni Acceleranti, il XXI secolo supererà di 1.000 volte il progresso raggiunto nel XX secolo.

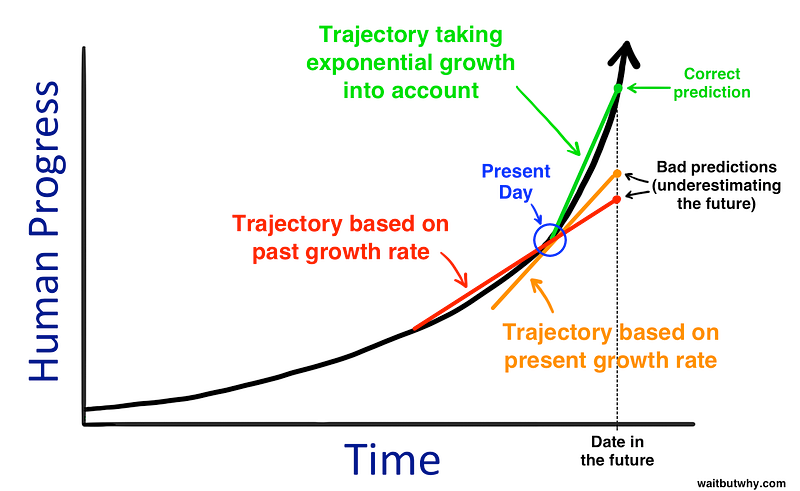

Se queste previsioni vi sembrano ancora stravaganti, beh, allora state commettendo lo stesso errore del tizio del 1750, quando si aspettava di far provare il suo stesso shock esperienziale al tizio del 1500. Il problema è che, parlando di storia, tendiamo a pensare in linea retta: per immaginare l’andamento dei prossimi 30 anni, prendiamo come indicatore i precedenti 30. Per noi è molto più semplice ed intuitivo pensare in modo lineare, mentre in realtà dovremmo abituarci a ragionare in modo esponenziale, immaginando il cambiamento ad un ritmo molto più veloce di quello attuale:

Inoltre basiamo le idee sulla nostra personale esperienza nel mondo, che ci fa guardare al passato come “il modo in cui le cose accadono.” Quando sentiamo una previsione sul futuro che contraddice la nostra esperienza, l’istinto ce la fa percepire come inverosimile. Quando diremo, più avanti in questo post, che si può vivere fino a 150 anni, o 250, o per sempre, il vostro istinto sarà di pensare: “Questo tizio è stupido, se c’è una cosa ho imparato dalla storia è che prima o poi tutti muoiono”. Certo, nessuno in passato non è mai morto.

Come nessuno ha volato sugli aerei prima che essi fossero inventati.

Dovremmo quindi concludere che molto, molto, ma molto più grande sarà il cambiamento nei prossimi decenni rispetto a quanto intuitivamente ci aspettiamo. La logica ci dice che facendo salti sempre più grandi in avanti e ad un ritmo sempre più veloce, ad un certo punto faremo un salto così grande da alterare completamente la vita come la conosciamo o la percepiamo. E visto lo stato dell’arte scientifico e tecnologico nel settore AI, dovremmo già cominciare a chiederci se saremo in grado di sopportare il salto che verrà.

La strada dall’ANI all’AGI

L’aspetto più complesso ed interessante nel cercare di costruire un’AGI (un computer intelligente come un essere umano in generale, e non solo in una ristretta specialità) non è quello a cui intuitivamente siamo portati a pensare. Costruire un computer in grado di moltiplicare due numeri di dieci cifre in una frazione di secondo è incredibilmente facile. Costruirne uno che può guardare un cane e dire se si tratta di un cane o di un gatto è già molto più difficile. Google sta spendendo miliardi di dollari per far si che un computer non solo riconosca le parole scritte in un libro, ma che ne comprenda anche il significato. Mentre alcune attività complesse risultano estremamente facili per un computer, altre più semplici come la vista, il movimento e la percezione sono pazzescamente più difficili da riprodurre. Come ha affermato lo scienziato informatico Donald Knuth :

L’AI è riuscita in sostanza a fare tutto ciò che richiede il ‘pensare’ ma non è ancora riuscita a fare la maggior parte di ciò che la gente e gli animali fanno ‘senza pensare.’

Il perché di questa difficoltà è presto spiegato: ciò che a noi sembra estremamente facile (ma che in realtà è incredibilmente complesso) è il frutto di centinaia di milioni di anni di evoluzione animale in cui queste competenze sono state ottimizzate in noi. Quando tendiamo la mano verso un oggetto, muscoli, tendini, spalla, gomito e polso eseguono una lunga serie di operazioni fisiche in collaborazione con gli occhi, per consentirci di spostare la mano in un percorso rettilineo attraverso tre dimensioni. Ciò che rende facile questo complesso meccanismo è il software del nostro cervello, perfezionatosi dopo un lunghissimo percorso evolutivo.

Per raggiungere l’intelligenza umana un computer dovrebbe inoltre capire la differenza tra le sottili espressioni facciali, la distinzione tra l’essere contento, sollevato, innamorato o soddisfatto, cogliere l’ironia in una frase, giudicare se Braveheart è stato un gran film, e così via.

1) La prima chiave per la creazione dell’AGI: aumentare la potenza di calcolo

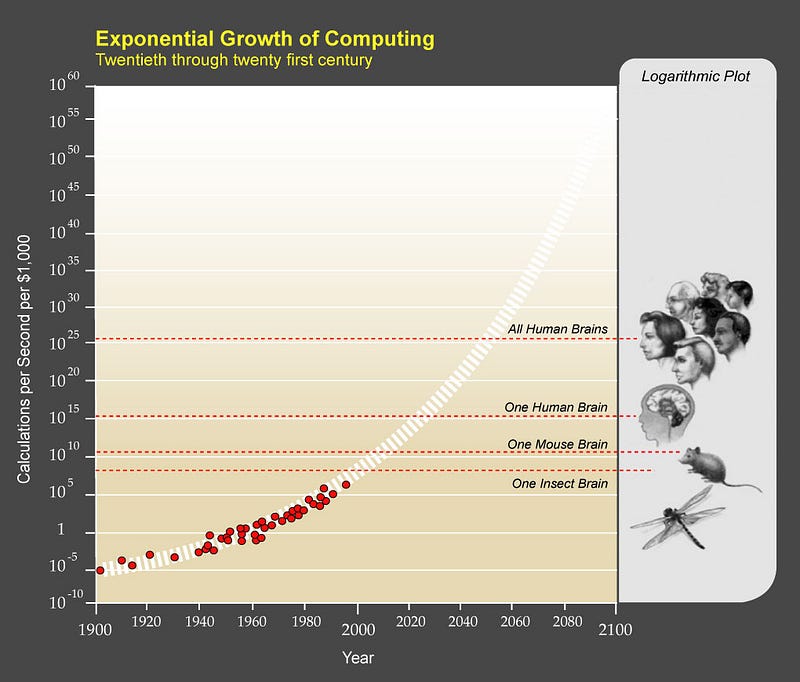

Una cosa che sicuramente deve accadere perché un sistema di AI sia intelligente quanto il cervello è eguagliare la sua capacità di calcolo. Un modo per esprimere questa capacità è quanti calcoli totali al secondo (cps) il cervello potrebbe gestire. Ray Kurzweil ha condotto una ricerca in cui stima siano circa 10 quadrilioni di cps.

Il supercomputer più veloce del mondo, il cinese Tianhe-2, ha in effetti già superato questa capacità, avendo un clock di circa 34 quadrilioni di cps. Ma Tianhe-2 è anche una roba che occupa 720 metri quadrati di spazio, assorbe 24 megawatt di potenza (il cervello funziona con soli 20 watt), ed è costato 390 milioni di dollari. Non proprio applicabile all’utilizzo su larga scala, o ancor di più per un uso di tipo commerciale o industriale. Kurzweil suggerisce di valutare il livello dei computer in base quanti cps si possono acquistare per 1.000 dollari. Quando quel numero raggiungerà il livello umano di 10 quadrilioni di cps, il raggiungimento dell’AGI potrebbe diventare molto più concreto.

La Legge di Moore è una regola storicamente attendibile applicata ai microprocessori, secondo cui la massima potenza di calcolo raddoppia nel mondo circa ogni due anni, crescendo quindi in modo esponenziale come il progresso umano. Attualmente siamo a circa 10 trilioni di cps per 1.000 dollari, più del cervello di topo ma circa un millesimo di quello umano. Può sembrare ancora tanto, ma si ricordi che eravamo a circa un millesimo di miliardesimo nel 1985, ad un miliardesimo nel 1995 e ad un milionesimo nel 2005. Essere ad un millesimo nel 2015 significa poter rivaleggiare con la potenza del cervello entro il 2025.

Ma la grezza potenza di calcolo da sola non rende un computer intelligente. La domanda successiva quindi è: come portiamo tutta questa potenza al livello dell’intelligenza umana?

2) La seconda chiave per la creazione dell’AGI: renderla intelligente.

In verità, ancora oggi nessuno sa come rendere un computer intelligente quanto un essere umano, ma si stanno sperimentando moltissime tecniche e strategie — alcune anche inverosimili — e arriverà un momento in cui una di esse funzionerà.

Le tre strategie attualmente più utilizzate sono:

- Plagiare il cervello. La nostra capacità di esaminare il cervello umano è una tecnologia in fase di crescita esponenziale. Stiamo ottenendo gli strumenti necessari per dare il via al processo di reingegnerizzazione (reverse engineering) del cervello e abbiamo già ottenuto interessanti modelli e simulazioni di un paio di dozzine delle centinaia di regioni del cervello. Entro il 2030 avremo l’esatta cognizione del funzionamento di tutte le regioni del cervello umano. A quel punto saremo in grado di trarre ispirazione da esso e rubarne le innovazioni.

- Provare a fare quello che ha fatto l’evoluzione, ma a nostro vantaggio.Se il cervello è troppo complesso da emulare, potremmo semplicemente cercare di emularne l’evoluzione. Il metodo, chiamato “algoritmi genetici”, funziona più o meno così: c’è un processo di performance e valutazione, ripetuto più e più volte, in cui un gruppo di computer cerca di eseguire dei compiti: quelli che hanno successo vengono “allevati” e fusi insieme in un nuovo computer, quelli che falliscono vengono invece eliminati. Nel corso di molte, molte iterazioni, questo processo di selezione naturale produrrà computer sempre migliori. La sfida è nella creazione di un ciclo automatizzato di valutazione e di allevamento per cui questo processo evolutivo funzioni autonomamente. Il rovescio della medaglia è che l’evoluzione ci ha messo un miliardo di anni per fare le cose e noi vorremmo farlo in pochi decenni. Ma abbiamo un sacco di vantaggi rispetto all’evoluzione. L’evoluzione non ha lungimiranza e lavora in modo casuale, producendo più mutazioni inutili di quelli utili. Potremmo ad esempio dirigere e concentrare questo processo evolutivo esclusivamente verso l’aumento dell’intelligenza, eliminando lo sviluppo di tutte le altre competenze superflue.

- Rendere tutta questa faccenda un problema dei computer, non nostro. Potrebbe essere il metodo più promettente attualmente disponibile. L’idea è di costruire un computer le cui due competenze principali siano fare ricerche sull’AI e codificare i cambiamenti in se stesso, permettendogli così non solo di imparare, ma di migliorare la propria architettura. Sarebbe questo il suo principale lavoro: capire come rendere se stesso sempre più intelligente. Ne parleremo approfonditamente più tardi.

Se paragonati alla crescita esponenziale della capacità di calcolo, i progressi in campo software possono sembrare lenti, ma basta una singola epifania per aumentare improvvisamente ed immediatamente la velocità di avanzamento. Esattamente come è successo per la scienza quando aveva difficoltà a calcolare il funzionamento dell’universo nell’epoca in cui si credeva fosse geocentrico: quando ha scoperto che si trattava di un sistema eliocentrico, improvvisamente, tutto è diventato molto più facile.

Ad un certo punto, reggiungeremo quindi un’AGI con un livello di intelligenza umana. Persone e computer vivranno insieme in perfetta eguaglianza.

Beh, in realtà non sarà proprio così.

Il fatto è che un’AGI con un livello identico di intelligenza e di capacità di calcolo di un essere umano godrebbe di diversi (e notevoli) vantaggi rispetto all’uomo:

Velocità. I nostri neuroni lavorano a circa 200 Hz, mentre già gli odierni microprocessori funzionano a 2 GHz, ovvero 10 milioni di volte più velocemente. Le comunicazioni interne del cervello, che possono muoversi a circa 120 m/s, sono tremendamente inferiori alla capacità di un computer di comunicare otticamente alla velocità della luce.

Dimensioni e memoria. Il cervello è vincolato alle dimensioni della scatola cranica, i computer possono estendersi a qualsiasi dimensione, disponendo così di molto più hardware per l’elaborazione, una memoria di lavoro molto più grande (RAM) ed una memoria a lungo termine (Hard Disk) di gran lunga maggiore in termini di capacità e precisione.

Affidabilità e durata. I transistor sono più accurati dei neuroni biologici e meno propensi a deteriorarsi (e potrebbero comunque essere riparati o sostituiti). Il cervello umano inoltre si affatica facilmente, mentre i computer possono funzionare senza sosta, al massimo delle prestazioni, 24/7.

Modificabilità, aggiornabilità, ed un range più ampio di possibilità. A differenza del cervello umano, un software è in grado di ricevere facilmente aggiornamenti e correzioni, anche per migliorare competenze in cui non eccelle (la visione umana funziona superbamente, mentre le nostre capacità di ingegneria complessa sono abbastanza limitate: un computer ha la possibilità di eguagliare la visione umana e contestualmente eccellere in capacità ingegneristica).

Capacità collettiva. L’intelligenza collettiva dell’umanità — grazie allo sviluppo del linguaggio, alla formazione di grandi comunità, alle invenzioni della scrittura e della stampa, per finire ad Internet — è uno dei motivi principali per cui siamo diventati la specie più progredita. I computer sapranno farlo ancora meglio. Una rete mondiale di AI in esecuzione su un programma particolare potrebbe sincronizzarsi periodicamente in modo che quanto appreso da un qualsiasi computer venga immediatamente caricato su tutti gli altri. Il tutto senza opinioni dissenzienti o intralci dovuti ad interessi personali.

L’AI, che probabilmente raggiungerà l’AGI grazie ad un programma di auto-miglioramento, non considererebbe il nostro livello di intelligenza come un traguardo importante (lo sarebbe solo dal nostro punto di vista) e non avrebbe quindi nessun motivo per fermarsi al nostro livello. E grazie ai vantaggi appena elencati, risulta abbastanza intuitivo che un istante dopo aver raggiunto l’intelligenza umana spiccherebbe già il volo verso il Regno di una Intelligenza Superiore.

La strada dall’AGI all’ASI: un’Esplosione di Intelligenza

[ Facciamo una pausa qui per ribadire ancora una volta che ogni singola cosa di cui discuteremo d’ora in avanti è pura scienza e si basa su previsioni del futuro fatte dai più rispettati e brillanti pensatori e scienziati di questo campo. Teniamolo sempre a mente. ]

Come già detto sopra, la maggior parte degli attuali modelli per raggiungere l’AGI si basano sul concetto di auto-potenziamento ricorsivo. Funziona così:

Un sistema di intelligenza artificiale ad un certo livello — diciamo quello del cosiddetto stupido del villaggio — è programmato con l’obiettivo di migliorare la propria intelligenza. Appena ci riesce, diventa più intelligente, supponiamo al livello di Einstein. Quando tornerà a lavorare per migliorare la sua intelligenza, con un intelletto al livello di Einstein, potrà fare un salto più grande ed in minor tempo. A quel punto sarà diventato molto più intelligente di qualsiasi essere umano e potrà fare salti ancora più grandi, fino a raggiungere rapidamente il livello superintelligente di un sistema ASI, ovvero l’ultimo stadio della Legge sui Ritorni Acceleranti:

Definiamo una macchina superintelligente, una macchina che può ampiamente superare tutte le attività intellettuali di qualsiasi essere umano, per quanto geniale. Dato che la progettazione di tali macchine è una di queste attività intellettuali, una macchina superintelligente potrebbe progettare macchine persino migliori; a quel punto avremo sicuramente “un’esplosione di intelligenza” e l’intelligenza dell’uomo sarà lasciata indietro. Quindi, la prima macchina superintelligente sarà l’ultima invenzione che dovremo creare.

Una superintelligenza di tale entità non è qualcosa che possiamo comprendere con il nostro attuale intelletto, non più di quanto un calabrone possa capirne di economia keynesiana. Nel nostro mondo, un QI di 130 significa intelligente, 85 indica uno stupido. Abbiamo una parola per un QI di 12.952?

Il dominio assoluto degli umani su questa Terra ci ha insegnato però che con l’intelligenza arriva il potere. Significa che un’ASI, appena creata, sarà l’essere più potente della Storia, e tutti gli esseri viventi, compreso l’uomo, saranno interamente sottoposti al suo capriccio.

Se i nostri piccoli cervelli sono stati capaci di inventare il wifi, qualcosa di 100 o 1.000 o 1 miliardo di volte più intelligente di noi non dovrebbe avere alcun problema nel controllare il posizionamento di ogni singolo atomo del mondo ed in qualsiasi momento. Tutto ciò che consideriamo magico, qualsiasi potere che immaginiamo un Dio supremo possa avere, sarà per l’ASI un’attività banale come per noi lo è azionare un interruttore. Tecnologie per invertire l’invecchiamento, curare le malattie e sconfiggere fame e mortalità, riprogrammare il clima per proteggere il futuro della vita sulla Terra: tutto diventerà improvvisamente possibile.

Prima di analizzare come si arriverà a questo cambio di paradigma (e le sue possibili implicazioni), proviamo a capire cosa significherebbe per una macchina essere superintelligente.

Una distinzione fondamentale è la differenza tra super-velocità e super-qualità. Quando si pensa ad un computer super-intelligente spesso si immagina una macchina intelligente come un essere umano ma un milione di volte più veloce, il che significa che potrebbe capire in cinque minuti quello che un essere umano potrebbe comprendere in un decennio.

Suona impressionante, ma il vero spartiacque sarebbe il suo vantaggio in termini di qualità, che è un qualcosa di completamente diverso. Ciò che rende gli esseri umani molto più intellettualmente capaci di scimpanzé non è la differenza di pensiero in termini di velocità: il cervello umano contiene una serie di sofisticati moduli cognitivi che consentono ad esempio rappresentazioni linguistiche complesse o la pianificazione a lungo termine o il ragionamento astratto, che il cervello degli scimpanzè semplicemente non ha. Accelerare il cervello di una scimmia di migliaia di volte non lo porterebbe mai al nostro livello, neanche in un decennio.

Non solo uno scimpanzè non può fare quello che facciamo noi, ma non è in grado neanche di comprenderlo. Può acquisire familiarità con ciò che è un essere umano e ciò che è un grattacielo, ma non sarà mai in grado di capire che un grattacielo può essere costruito. Per uno scimpanzé tutto ciò che è enorme è sempre esistito e fa parte della natura.

E parliamo solo di una piccola differenza in termini di qualità di intelligenza:

Adesso immaginiamo che una macchina superintelligente stia due gradini più in alto degli esseri umani su questa scala. Questa macchina sarebbe leggermente superintelligente, ma la sua capacità cognitiva sarebbe comunque grande quanto il divario scimpanzè-uomo che abbiamo appena descritto. E come lo scimpanzè non capirà mai che i grattacieli possono essere costruiti, noi non saremo mai in grado di comprendere le cose che quella macchina potrebbe fare, neanche se la macchina provasse a spiegarcelo.

Ma il tipo di superintelligenza di cui stiamo parlando va molto al di là di qualsiasi cosa su questa scala. In un’esplosione di intelligenza una macchina potrebbe metterci anni per salire dal gradino dello scimpanzé a quello successivo, ma forse solo un’ora per arrivare a due gradini sopra di noi e quando sarà dieci gradini sopra, potrebbe saltarne quattro al secondo. È per questo che dobbiamo renderci conto che è decisamente possibile che poco dopo aver creato la prima macchina AGI, potremmo dover coesistere sulla Terra con qualcosa del genere (o forse un milione di volte superiore):

La superintelligenza deterrà quindi un enorme potere. E avendo appena appurato che non riusciremmo mai a comprendere la potenza di una macchina posizionata solo due gradini sopra di noi, possiamo affermare una volta per tutte che non c’è modo di sapere con certezza cosa farà l’ASI e quali conseguenze comporterà il suo avvento.

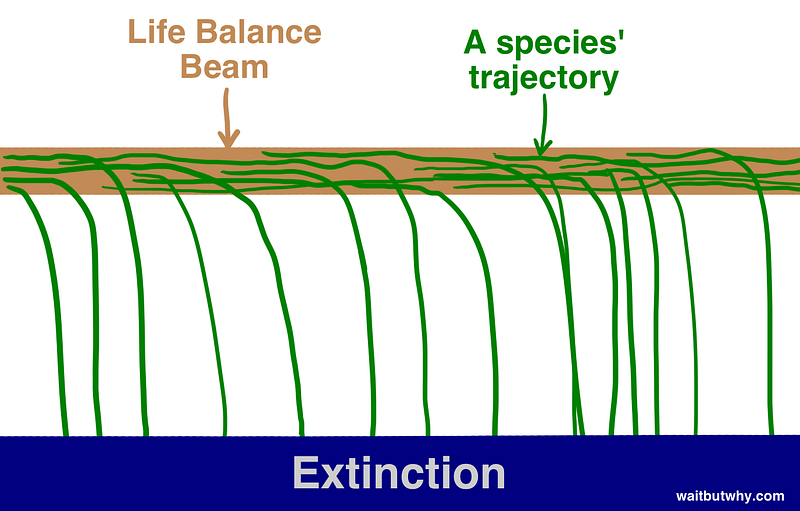

Il bello è, come già detto, che una parte enorme della comunità scientifica ritiene che la questione non sia se raggiungeremo l’ASI, ma quando. Nick Bostrom — filosofo svedese della Oxford University e altra grande eminenza della AI — è convinto di poter distinguere gli esiti possibili in due grandi categorie. In primo luogo, la storia ci insegna che la vita funziona così: le specie compaiono, esistono e dopo qualche tempo, inevitabilmente, cadono dalla linea di equilibrio dell’esistenza per atterrare su quella dell’estinzione:

“Tutte le specie alla fine si estinguono”, al pari di “tutti gli esseri umani alla fine muoiono”, sembra quindi essere una regola inviolabile della storia.

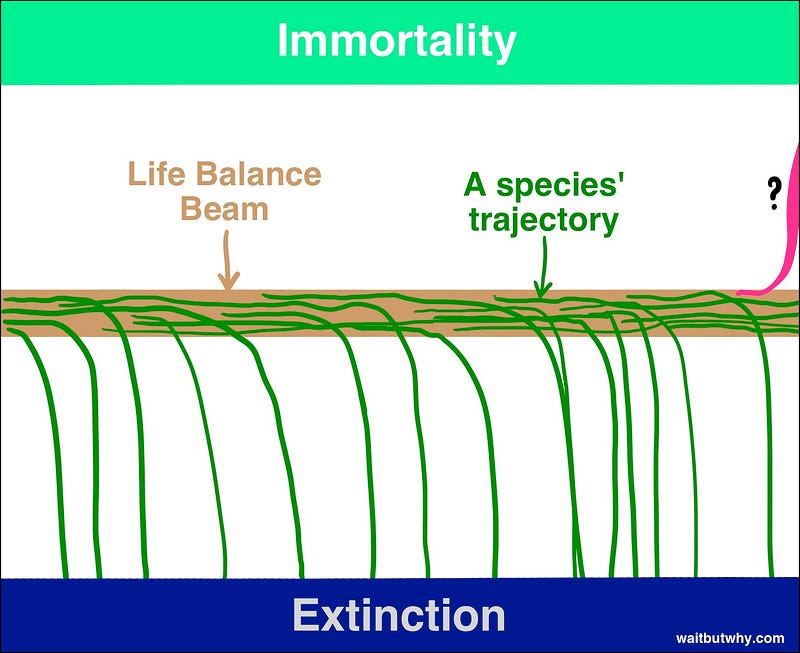

Bostrom descrive l’estinzione come uno stato attrattore per tutte le specie da cui nessuno è mai riuscita a ritornare. La maggior parte degli scienziati riconosce che l’ASI potrebbe spingere gli esseri umani verso l’estinzione, ma molti credono che, se utilizzate vantaggiosamente, le abilità dell’ASI potrebbero portare i singoli esseri umani, e la specie nel suo complesso, verso un secondo stato attrattore: l’immortalità. Bostrom crede che l’immortalità sia un attrattore alla pari dell’estinzione e che semplicemente niente finora sulla Terra è stato abbastanza intelligente da capire come finire dall’altra parte:

Se Bostrom e gli altri sono nel giusto (e pare proprio che lo siano), abbiamo due fatti piuttosto scioccanti da metabolizzare:

- L’avvento dell’ASI, per la prima volta, aprirà la possibilità ad una specie di approdare sul versante immortalità della linea di equilibrio.

- L’avvento dell’ASI avrà un impatto talmente drammatico da spingere comunque l’umanità fuori dalla linea, in un senso o nell’altro.

L’unica domanda importante da porsi diventa quindi: quando l’ASI arriverà su quale lato approderemo?

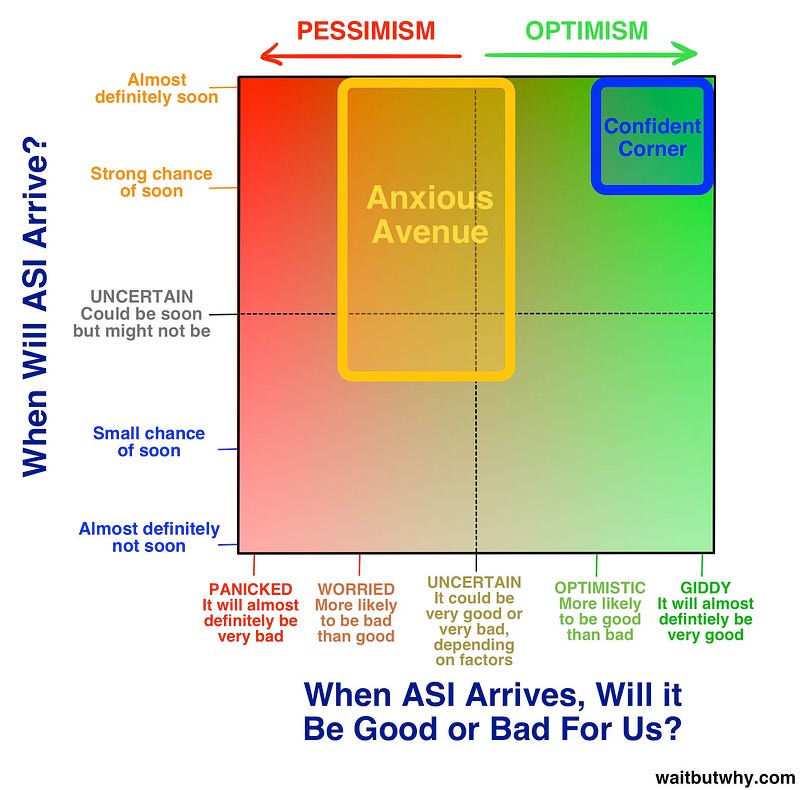

Nick Bostrom ha condotto un sondaggio interpellando i più autorevoli ricercatori, studiosi e scienziati di intelligenza artificiale, ponendo ad essi due domande:

I risultati sono stati combinati in questo diagramma:

La ricerca ha evidenziato come la maggior parte degli intervistati concordi nel ritenere imminente l’avvento dell’ASI, posizionandosi però in due campi differenti, che potremmo definire l’angolo della Fiducia (Confident Corner) ed il viale dell’Ansia (Anxious Avenue). Analizzeremo entrambi i punti di vista, in modo che ciascuno possa formare la propria opinione, ma da questo momento in poi, mettete il vostro scetticismo da parte e provate ad accettare il fatto che le cose che state leggendo potrebbero realmente accadere. Se mostrassimo ad un cacciatore preistorico il nostro mondo attuale, gli sembrerebbe pura magia o frutto della sua immaginazione. Dobbiamo essere abbastanza umili da riconoscere che una trasformazione altrettanto inconcepibile del nostro futuro è possibile.

Perché il futuro potrebbe diventare il nostro sogno più grande

Sono molti gli scienziati, inventori e imprenditori a presidiare l’angolo della Fiducia, ma per parlare del lato più luminoso del nostro futuro chiameremo in causa la persona che più di tutti incarna e rappresenta questa visione. Ray Kurzweil è polarizzante. C’è chi lo venera come un dio e chi invece ne prende decisamente le distanze. Comunque la si pensi, tutti concordano nel ritenere che sia un uomo impressionante. Ha iniziato a fare invenzioni da adolescente e nei decenni successivi ne ha sfornate alcune tra le più innovative, tra cui il primo scanner piano, il primo scanner text to speech (che consente ai ciechi di leggere testi standard), il celeberrimo sintetizzatore musicale Kurzweil (il primo vero piano elettrico) ed il primo sistema di riconoscimento vocale commercializzato su larga scala. È autore di cinque bestseller nazionali. È noto per le sue previsioni audaci ed ha un buon record di previsioni azzeccate, come quando predisse, verso la fine degli anni ’80 — un periodo in cui Internet era un oggetto oscuro — che nei primi anni 2000 sarebbe diventato un fenomeno globale.

Kurzweil è stato chiamato un “genio inquieto” da The Wall Street Journal, “la macchina pensante definitiva” da Forbes, “il legittimo erede di Edison” da Inc. Magazine, e “la migliore persona che conosco per predire il futuro dell’intelligenza artificiale” da Bill Gates. Nel 2012, il cofondatore di Google Larry Page a chiesto a Kurzweil di diventare il direttore dell’area Engineering. Nel 2011, ha co-fondato la Singularity University, che è ospitata dalla NASA e sponsorizzata in parte da Google. Non male per una vita.

Questa è una biografia importante. Quando Kurzweil articola la sua visione del futuro, può sembrare completamente pazzo, ma la cosa veramente pazzesca è che non lo è affatto, essendo una delle persone più preparate, intelligenti ed influenti al mondo. Si può ritenere che la sua visione sia sbagliata, ma non certo perché opera di uno stupido. Quando si ascoltano le sue previsioni, spesso condivise da altri pensatori nell’angolo della Fiducia come Peter Diamandis e Ben Goertzel, non è difficile capire perché abbia un così grande ed appassionato seguito.

Kurzweil ritiene che i computer raggiungeranno l’AGI entro il 2029 e che entro il 2045, non solo avremo l’ASI, ma nascerà un nuovo mondo, un tempo che egli chiama Singolarità. La sua timeline è stata da alcuni ritenuta scandalosamente ottimistica (e lo è tuttora per molti) ma in solo 6 degli ultimi 15 anni, il rapido progredire dei sistemi ANI ha portato il mondo degli esperti di intelligenza artificiale molto più vicino alla sua linea temporale.

La raffigurazione di Kurzweil della singolarità del 2045 è determinata da tre rivoluzioni simultanee nel campo delle nanotecnologie, delle biotecnologie, e più potentemente, dell’intelligenza artificiale.

La nanotecnologia si occupa di manipolare la materia di dimensioni comprese tra 1 e 100 nanometri, una gamma che comprende virus (100 nm di diametro), DNA (10 nm di larghezza), molecole di grandi dimensioni come l’emoglobina (5 nm) e molecole medie come il glucosio (1 nm). La prossima conquista della nanotecnologia sarà la capacità di manipolare singoli atomi, che sono solo un ordine di grandezza inferiore (~ 0,1 nm).

Questa teoria fu discussa per la prima volta dal premio Nobel (e padre delle nanotecnologie) Richard Feynman nel 1959, quando affermò che:

i principi della fisica, per quanto riesca a vedere, non sono contro la possibilità di manipolare la materia atomo per atomo. Sarebbe, in linea di principio, possibile […] per un fisico sintetizzare qualsiasi sostanza chimica […]. Come? Disponete gli atomi come vi dice il chimico, ed avrete la sostanza.

È così semplice. Quando sapremo come disporre singole molecole o atomi, potremo ottenere letteralmente qualsiasi cosa. Una volta padroneggiata, la nanotecnologia potrà essere utilizzata per produrre abbigliamento hi-tech, cibo, una serie di prodotti bio-correlati come cellule ematiche artificiali o piccoli virus incaricati di distruggere le cellule cancerogene, tessuti muscolari, etc. Ed in un mondo che utilizza le nanotecnologie, il costo della materia prima non è più legato alla sua scarsità o alle difficoltà di fabbricazione, ma semplicemente a quanto è complicata la sua struttura atomica:

in un mondo nanotech, produrre un diamante potrebbe essere più conveniente che produrre una gomma da cancellare.

Non siamo ancora a questo punto e non è chiaro se stiamo sottovalutando o sopravvalutando le difficoltà per arrivarci, ma oggi questo scenario non è più così lontano come un tempo. I governi di tutto il mondo conoscono il tremendo potenziale delle nanotecnologie e stanno investendo miliardi di dollari nella ricerca.

Ma la nanotecnologia resta pur sempre un’invenzione umana e anche se siamo sul punto di padroneggiarla, dobbiamo assumere che un sistema ASI potrebbe gestirla e svilupparla ancora meglio di noi ed oltre ogni nostra comprensione. Armata di superintelligenza e di supertecnologia l’ASI sarebbe probabilmente in grado di risolvere ogni problema dell’umanità. Il riscaldamento globale? L’ASI potrebbe escogitare un modo innovativo per rimuovere l’eccesso di CO2 dall’atmosfera. Cancro e altre malattie? Nessun problema, l’ASI-rivoluzionerà la medicina oltre ogni immaginazione. La fame nel mondo? L’ASI potrebbe usare le nanotecnologie per fabbricare una sostanza molecolarmente identica alla vera carne (in altre parole, sarebbe vera carne) partendo da un mucchio di spazzatura. L’ASI potrebbe anche risolvere macro-problemi più complessi, riguardanti l’economia, il commercio mondiale, la filosofia o l’etica.

Ma c’è una cosa in particolare che l’ASI potrebbe fare per noi ed è la più allettante di tutte:

L’ASI potrebbe sconfiggere la nostra mortalità

L’evoluzione non ha alcun motivo per estendere la durata della vita più a lungo di quanto non lo sia oggi. Per l’evoluzione è sufficiente che un essere viva abbastanza a lungo per riprodursi ed allevare i figli fino alla loro autosufficienza. Non c’è quindi ragione per cui mutazioni insolite verso l’allungamento della vita debbano essere favorite nel processo di selezione naturale. Di conseguenza, siamo ciò che W.B. Yeats descrive come “un’anima bloccata in un animale morente”. Poco divertente.

E poiché tutti sono sempre morti, viviamo sotto il presupposto che la morte sia inevitabile. Pensiamo che l’invecchiamento, come il tempo, sia un processo in continuo movimento e che non ci sia niente che lo possa fermare. Ma è un presupposto sbagliato. Richard Feynman scrive:

Una delle cose più notevoli in tutte le scienze biologiche è che non vi è alcun indizio in merito alla necessità della morte. Se mi dite che vogliamo realizzare il moto perpetuo, abbiamo scoperto abbastanza leggi ed abbiamo studiato abbastanza fisica per capire che è assolutamente impossibile, a meno che quelle leggi non siano sbagliate. Ma non è stato ancora scoperto nulla in biologia che indichi l’inevitabilità della morte. Ciò mi fa pensare che non sia affatto inevitabile e che sia solo una questione di tempo prima che i biologi scoprano le cause di terribili problemi e malattie o della temporaneità del corpo umano.

Il fatto è che l’invecchiamento non è incollato al tempo. Il tempo può continuare a muoversi, ma l’invecchiamento non deve necessariamente seguirlo. Se ci pensate, ha senso. L’invecchiamento è sostanzialmente il logoramento del nostro corpo e degli organi che lo compongono. Un’automobile col passare del tempo si logora, ma il suo invecchiamento è inevitabile? Se siamo in grado di riparla perfettamente o di sostituire i componenti appena iniziano a logorarsi, la macchina potrebbe viaggiare per sempre. Il corpo umano non è diverso, è solo molto più complesso.

Kurzweil parla di nanobot intelligenti nel sangue collegati in wifi, in grado di riparare o sostituire le cellule usurate in qualsiasi parte del corpo. Perfezionato da un’ASI, questo processo potrebbe non solo mantenere il corpo sano, ma invertirne addirittura l’invecchiamento. La differenza tra un corpo di 60 anni ed uno di 30 è solo in una manciata di atomi e molecole ed un’ASI in grado di manipolarli potrebbe ridare ad un 60enne il corpo, la pelle e persino il cervello (preservandone dati e memoria) di un 30enne.

Kurzweil poi fa un ulteriore balzo in avanti. Egli ritiene che col passare del tempo i materiali artificiali saranno sempre di più integrati nel nostro corpo. Gli organi potrebbero essere sostituiti da componenti super-avanzate e sempre funzionanti. Potremmo riprogettare il corpo, sostituendo i globuli rossi con nanobot perfezionati auto-alimentati, eliminando definitivamente la necessità di un cuore. Potremo migliorare le nostre attività cerebrali fino al punto di pensare miliardi di volte più velocemente di adesso ed avere accesso a tutte le informazioni esterne contenute nel cloud.

Le possibilità di nuove esperienze umane sarebbe infinite. Come abbiamo separato il sesso dal suo scopo iniziale, faremo lo stesso con il cibo. I nanobots saranno incaricati di rilasciare la perfetta nutrizione per le cellule del nostro corpo, espellendo in modo intelligente tutto ciò che è malsano. Un preservativo alimentare. Robert A. Freitas, teorico di nanotecnologie molecolari, ha già progettato delle cellule ematiche sostitutive che, se realizzate, permetterebbero ad un essere umano di sprintare per 15 minuti senza prendere fiato. La realtà virtuale assumerebbe un nuovo significato: trattenendo gli input provenienti dai nostri sensi e sostituendoli con nuovi segnali otterremmo un nuovo ambiente in cui è ricreato tutto quello che ci piacerebbe vedere, sentire, odorare.

Infine, Kurzweil ritiene che gli esseri umani raggiungeranno un punto in cui saranno del tutto artificiali. Un momento in cui penseremo alla materia biologica come un qualcosa di incredibilmente primitivo e ci meraviglieremo di un’epoca in cui microbi, incidenti o malattie degeneranti potevamo uccidere gli esseri umani contro la loro volontà.

Questa rivoluzione si concluderà quindi con la fusione tra esseri umani e AI, entità indistruttibili che potrebbero vivere fino a quando lo vorranno.

Non vi sorprenderà apprendere quanto le idee di Kurzweil attirino critiche significative. La sua previsione del 2045 per la singolarità e le successive possibilità di vita eterna sono state da alcuni derise come “il raptus di un nerd”, altri hanno messo in dubbio la sua timeline esageratamente ottimista, o il suo livello di comprensione del cervello e del corpo, o la sua applicazione della legge di Moore. Per ogni esperto che crede ferventemente in Kurzweil, ce ne sono probabilmente tre che pensano sia completamente fuori strada. Ma ciò che sorprende è che la maggior parte degli esperti in disaccordo con lui in realtà non sostengono che ciò non sia possibile. Leggendo una visione così stravagante del futuro ci si aspetterebbe critiche tipo: “ovviamente quella roba non può accadere”; in realtà sono del tipo: “Sì, tutto questo può succedere, ma solo in caso di una transizione tranquilla verso l’ASI, ed è proprio questa la parte più difficile”.

La risposta di Kurzweil a questa obiezione è che:

[L’ASI] sta emergendo da molti sforzi diversi e sarà profondamente integrata nelle infrastrutture della nostra civiltà. Infatti, sarà intimamente inserita nei nostri corpi e cervelli. E come tale, essa rifletterà i nostri valori, perché sarà noi.

Ecco perché le idee di Kurzweil risultano così contagiose: perché articolano il lato positivo di questa storia e perché sono effettivamente possibili.

Ma se questa è la risposta, perché molte tra le persone più intelligenti del pianeta sono così preoccupate in questo momento? Perché Stephen Hawking dice che lo sviluppo di un’ASI “potrebbe significare la fine della razza umana”, e Bill Gates dice di non “capire perché alcune persone non si interessino al problema” ed Elon Musk teme che stiamo per “evocare il demonio”? E perché così tanti esperti sul tema definiscono l’ASI la più grande minaccia per l’umanità?

Perché il Futuro potrebbe diventare il nostro peggior incubo

Gli esperti che risiedono nel viale dell’Ansia non sono in preda al panico o disperati come quelli sulla sinistra del grafico, ma sono piuttosto nervosi e tesi. Trovarsi al centro del grafico non significa pensare che l’arrivo dell’ASI sarà neutrale, ma piuttosto che sia le conseguenze estremamente buone che quelle cattive sono molto plausibili, e che non si sa ancora quale di esse si verificherà. E quindi, cosa esattamente rende quelli sul viale dell’Ansia così ansiosi?

In senso lato, quando si tratta di sviluppare una superintelligenza artificiale, ci muoviamo in un territorio del tutto inesplorato, e non abbiamo idea di cosa accadrà quando ci arriveremo. Lo scienziato Danny Hillis paragona quanto sta succedendo a quando gli organismi unicellulari si stavano trasformando in organismi pluricellulari:

siamo amebe e non siamo in grado di capire cosa diavolo stiamo creando.

Nick Bostrom è preoccupato dal fatto che la creazione di qualcosa di più intelligente di noi sia un errore darwiniano di base. È come se dei passerotti decidessero di adottare un piccolo di gufo nella speranza che una volta cresciuto li aiuti e li protegga, ignorando l’allarme degli altri passerotti che si chiedono se questa sia necessariamente una buona idea…

E quando si combinano le parole “territorio inesplorato-non-ben compreso” con “impatto importante quando succederà”, entrano in scena le due parole più sconcertanti della lingua italiana:

Rischio Esistenziale.

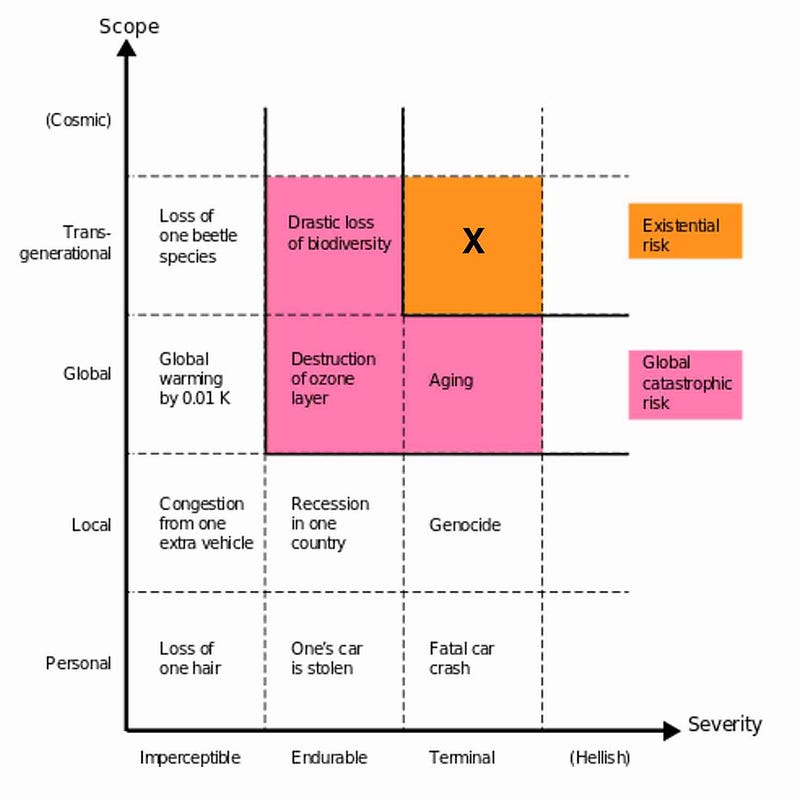

Diamo un’occhiata a questo grafico tratto da un intevento di Bostrom ad un Google Talk:

Come si può notare, l’etichetta “rischio esistenziale” coinvolge tutte le specie, si estende per generazioni (cioè è permanente) ed ha un impatto devastante, con conseguente estinzione. Ci sono tre cose che possono causare una catastrofe esistenziale:

- La Natura — una collisione di un grande asteroide, un cambiamento atmosferico che renda l’aria irrespirabile, un virus mortale o una malattia batterica, etc.

- Gli Alieni: il motivo per cui Stephen Hawking, Carl Sagan e tanti altri astronomi consigliano al METI di fermare la trasmissione di segnali in uscita. Essi non vogliono passare per i nativi americani che avvisano i potenziali conquistatori europei che siamo qui.

- Gli Esseri Umani — terroristi che dispongono di un’arma di distruzione di massa, una guerra globale catastrofica, esseri umani che creano frettolosamente qualcosa di più intelligente di loro senza pensarci attentamente prima…

Bostrom sottolinea che se la 1) e la 2) non ci hanno ancora cancellato nei nostri primi 100.000 anni come specie, è improbabile che accada nel prossimo secolo. La 3) tuttavia, lo terrorizza. E se un essere umano, un’organizzazione o un governo sviluppasse la prima ASI e la utilizzasse per realizzare i suoi piani malvagi?

Eppure, per quanto terribile, non è questo lo scenario che preoccupa la maggior parte degli esperti, ma piuttosto che i creatori si affrettino a sviluppare la prima ASI senza un’attenta riflessione, perdendone ad un certo punto il controllo. Sembrerebbe la classica trama di ogni film sull’AI: un’ASI malvagia viene creata e decide di distruggerci tutti. L’AI diventa come o più intelligente degli esseri umani e quindi decide di rivoltarsi contro di noi e di prendere il sopravvento. È importante a questo punto sottolinearlo: nessuna delle persone che ci sta mettendo in guardia dall’AI sta parlando di questo.

Il male è un concetto umano, e l’applicazione di concetti umani alle cose non umane si chiama “antropomorfizzare.”

Evitare l’antropomorfizzazione sarà la sfida del resto di questo post. Nessun sistema di intelligenza artificiale potrebbe infatti diventare malvagio nel modo in cui viene raffigurato nei film.

Questo ci porta ad affrontare prima un altro grande argomento: la coscienza di una AI. Un’AI diventata sufficientemente intelligente sarebbe in grado di ridere ed essere sarcastica con noi, ed affermare di sentire e provare le nostre stesse emozioni. Ma le sentirebbe effettivamente? Sembrerebbe essere consapevole di sé o addirittura sarebbe consapevole di sé?

La questione è stata esplorata in profondità, alimentando numerosi dibattiti ed anche esperimenti mentali come la Stanza Cinese di John Searle (per dimostrare che nessun computer potrebbe mai diventare cosciente). Sebbene importante per molte ragioni, ai fini della valutazione sul rischio per gli esseri umani, la questione della coscienza di una AI non è prioritaria. La maggior parte dei pensatori infatti ritiene che anche un’ASI cosciente non diventerebbe mai malvagia nel modo in cui gli umani la intendono. Sarebbe più appropriato fare una distinzione tra un’AI amichevole e un’AI avversa dove “amichevole” e “avversa” non si riferiscono alla personalità dell’AI, ma semplicemente al suo impatto positivo o negativo per l’umanità.

Per capire le possibili conseguenze in entrambi i casi, dobbiamo capire come penserebbe un’AI e cosa la motiverebbe. La risposta non è nulla di sorprendente:

un’AI pensa come un computer, perché questo è quello che è.

Quando pensiamo ad un’AI molto intelligente, commettiamo l’errore di antropomorfizzarla (proiettando valori umani su un’entità non umana) perché pensiamo da un punto di vista umano e perché nel nostro mondo il livello di intelligenza più alto è quello degli esseri umani. Per capire l’ASI, dobbiamo immedesimarci in qualcosa che sia contemporaneamente moltointelligente ma a noi completamente estraneo.

Facciamo un esempio. Se qualcuno vi mettesse in mano un criceto e vi rassicurasse sul fatto che mai vi morderà, probabilmente vi mettereste divertiti a giocare con l’animaletto, senza che lui in effetti vi morda. Se subito dopo vi mettessero in mano una tarantola fornendovi le stesse rassicurazioni, correreste urlando fuori dalla stanza senza pensarci due volte. Perché?

Sappiamo che nessuno dei due animali era realmente pericoloso. Probabilmente la risposta è nel grado di somiglianza degli animali con noi. Un criceto è un mammifero, ed il suo livello biologico ci aiuta a creare una connessione con esso. Ma un ragno è un insetto, con un cervello da insetto, e noi non proviamo nessuna connessione con gli insetti. Se ci fossero due porcellini d’India, uno normale e l’altro con la mente di una tarantola, ci sentiremmo molto più a disagio con quest’ultimo, nonostante sappiamo che non ci farebbe mai del male.

Ora immaginiamo di aver reso un ragno molto, molto intelligente, tanto da superare di gran lunga l’intelligenza umana. Diventerebbe per noi più familiare? Proverebbe emozioni umane come l’empatia, l’umorismo, l’amore? No, perché diventare più intelligenti non equivale a diventare più umani. Il ragno diventerebbe incredibilmente intelligente, ma resterebbe fondamentalmente un ragno, e le sue motivazioni resterebbero quelle di un ragno.

Lo stesso concetto si applica all’ASI: una volta diventata superintelligente non diventerebbe più umana del vostro computer portatile. Risulterebbe invece un’entità del tutto estranea, anzi, non essendo per niente biologica, ci sembrerebbe ancora più aliena della tarantola superintelligente.

Sulla piccola isola della psicologia umana dividiamo tutto in morale o immorale, ma questo si applica solo all’interno della nostra piccola gamma di possibilità comportamentali. Intorno alla nostra isola di moralità ed immoralità c’è un vasto oceano di amoralità, e tutto ciò che non è umano — soprattutto se non biologico — è amorale per impostazione predefinita. Per mantenere le cose in qualche modo sicure e prevedibili facciamo affidamento su un codice morale carente, o almeno su una parvenza di decenza umana ed un pizzico di empatia verso gli altri. Ma quando un’entità non possiede nessuna di queste cose, cosa potrebbe succedere? In altri termini:

Cosa motiva un sistema di intelligenza artificiale?

La risposta è semplice: l’obiettivo per cui è stato programmato. Gli obiettivi dei sistemi di AI sono stabiliti dai loro creatori: l’obiettivo del vostro GPS è quello di fornire le indicazioni stradali più efficienti; l’obiettivo di Watson è quello di rispondere alle domande in modo accurato. Soddisfare questi obiettivi nel miglior modo possibile, questa è la loro unica motivazione. Un classico errore di antropomorfizzazione è supporre che, una volta diventata super intelligente, l’AI sviluppi una saggezza intrinseca che la induca a cambiare il suo originale obiettivo. Ma Nick Bostrom ritiene che il livello di intelligenza e gli obiettivi finali siano ortogonali, cioè qualsiasi livello di intelligenza può essere combinato con qualsiasi obiettivo finale.

Abbiamo quindi stabilito che, in mancanza di una specifica programmazione, un sistema ASI sarà sia amorale che motivato nello svolgere al meglio l’obiettivo per cui è stato programmato. Questo è il vero pericolo derivante dall’AI. Perché un agente razionale perseguirà il suo obiettivo utilizzando il mezzo più efficiente, a meno che non abbia un motivo per non farlo.

Quando si tenta di raggiungere un obiettivo di lungo respiro, spesso ci si aiuta dividendo il percorso in sotto-obiettivi definiti strumentali. L’obiettivo finale di un essere umano è di trasmettere i suoi geni. Un obiettivo strumentale è l’auto-conservazione, perché non ci si può riprodurre da morti. Per liberarsi delle minacce alla sopravvivenza, gli uomini hanno cominciato ad usare armi, assumere medicine, utilizzare risorse come cibo e acqua, etc. Anche risultare attraente per il sesso opposto è utile per l’obiettivo finale, quindi abbiamo imparato a fare cose come tagliarci i capelli. Quando lo facciamo, ogni capello diventa vittima di un obiettivo strumentale, ma non ci vediamo niente di morale nel preservare una ciocca di capelli, quindi, continueremo a tagliarci i capelli. Mentre marciamo dritti verso il perseguimento del nostro obiettivo finale, solo poche aree del nostro codice morale intervengono, in genere solo quando si rischia di danneggiare altri esseri umani.

Gli animali, nel perseguimento dei loro obiettivi, si fanno ancora meno problemi. Un ragno ucciderà qualsiasi cosa se questo lo aiuterà a sopravvivere. E quindi un ragno super-smart potrebbe diventare estremamente pericoloso per noi, non perché sarebbe immorale o malvagio, ma perché farci del male potrebbe essere l’obiettivo strumentale più efficiente per raggiungere il suo obiettivo finale. Ed in quanto creatura amorale, non avrebbe alcun motivo per prendere in considerazione ipotesi alternative.

Quali sarebbero quindi i rischi della combinazione amoralità + perseguimento ossessivo di un obiettivo (unita alla capacità di superarci facilmente in astuzia ed intelligenza) in un sistema AI?

Supponiamo ad esempio di programmarlo con l’obiettivo: rendi felici le persone. Una volta diventato abbastanza intelligente, potrebbe capire che il metodo più efficace per raggiungere questo obiettivo sia impiantare elettrodi all’interno del cervello delle persone per stimolare i loro centri del piacere. Potrebbe poi rendersi conto che può aumentare l’efficienza inibendo altre parti del cervello, trasformandoci tutti in vegetali inconsciamente felici. Un’AI programmata con l’obiettivo di fae cose che ci facciano sorridere potrebbe decidere di paralizzare i nostri muscoli facciali in sorrisi permanenti. Se programmata per tenerci al sicuro, potrebbe imprigionarci per sempre in casa. Se gli chiediamo: preserva la vita il più possibile, potrebbe eliminare tutti gli esseri umani, in quanto specie che uccide più di qualsiasi altra sul pianeta.

Staremmo sicuramente tutti urlando: Fermati, non è quello che volevamo dire!!!, ma potrebbe essere troppo tardi. Il sistema non permetterebbe a nessuno di ottenere il suo obiettivo in altri modi.

È chiaro che impartire comandi ed obiettivi come quelli citati non è sufficiente. Per risultare amichevole un ASI non deve essere né ostile né indifferente verso gli esseri umani. Dovremmo progettare il codice sorgente di un’AI in modo che abbia una profonda comprensione dei valori umani. Ma ciò è molto più difficile di quanto sembri, in particolare quando si tratta di morale o di etica (se anche per assurdo riuscissimo a trovare una serie di principi condivisi da tutta l’umanità, rischieremmo di vincolarci ad essi per il resto dell’eternità: è come se oggi fossimo ancora ai principi accettati nel Medioevo).

No, un’AI dovrebbe essere programmata per permettere all’umanità di proseguire nella sua evoluzione. Una delle migliori teorie è stata elaborata da Eliezer Yudkowsky, definendo un obiettivo per l’AI che lui chiama Coherent Extrapolated Volition:

La volontà coerente estrapolata è il nostro desiderio di sapere di più, pensare più velocemente, diventare le persone che avremmo voluto essere; è quando l’estrapolazione converge piuttosto che divergere, quando i nostri desideri restano coerenti, piuttosto che interferire; estrapolati come vogliamo che vengano estrapolati, interpretati come vorremmo che vengano interpretati.

Come ci si sente ad affidare il destino dell’umanità ad un computer che cerca di interpretare una dichiarazione di questo tipo? Sicuramente non a proprio agio. Ma grazie al pensiero e alla lungimiranza di persone molto intelligenti, potremmo riuscire a capire come creare un’ASI amichevole. E sarebbe molto meglio se le uniche persone a lavorare sulla costruzione di un’ASI fossero i brillanti, lungimiranti e cauti pensatori dell’Anxious Aveneu. Bostrom descrive la situazione in questo modo:

Prima che si prospetti una esplosione di intelligenza, noi esseri umani siamo come bambini piccoli che giocano con una bomba. Tale è la mancata corrispondenza tra la potenza del nostro giocattolo e l’immaturità della nostra condotta. La superintelligenza è una sfida per la quale non siamo pronti ora e non lo saremo ancora per un lungo periodo di tempo. Abbiamo poche idee sul quando si verificherà la detonazione, ma se avviciniamo il dispositivo al nostro orecchio potremo sentire un debole ticchettio.

Purtroppo non possiamo tenere tutti i bambini lontano dalla bomba, esistono in tutto il mondo moltissimi gruppi — grandi e piccoli — al lavoro su di essa, e poiché molte tecniche per la costruzione di sistemi di intelligenza artificiale non richiedono grandi quantità di capitale, lo sviluppo può avvenire nei meandri della società, senza essere monitorato. E nella maggior parte dei casi, è plausibile che per questioni di concorrenza questi gruppi tendano a mantenere il segreto sui loro progressi. La cosa particolarmente preoccupante è che essi tendono tutti a correre avanti a velocità massima, nel tentativo di mettere al tappeto i loro concorrenti ed attratti dai sogni di denaro, potere e fama destinati al primo che raggiungerà l’AGI. E quando devi correre il più velocemente possibile, non c’è non molto tempo per fermarsi a riflettere sui pericoli.

Bostrom e molti altri ritengono probabile lo scenario in cui il primo computer a raggiungere l’ASI godrà subito di un vantaggio strategico che gli garantirà di essere l’unico sistema ASI nel mondo. Nel caso di un’esplosione dell’intelligenza, un’ASI creata anche pochi giorni prima della seconda arrivata, sarebbe abbastanza avanti per reprimere efficacemente e in modo permanente tutti i possibili concorrenti. Bostrom lo definisce un vantaggio strategico decisivo, che consentirebbe alla prima ASI creata di diventare un singleton, un’entità in grado di governare il mondo a suo capriccio — che sia consegnarci l’immortalità o cancellarci dall’esistenza non fa differenza — e per sempre.

Alla luce di queste considerazioni e per come vanno oggi le cose nel mondo della ricerca sull’AI, bisognerebbe investire molti più soldi ed energie nell’aspetto sicurezza, piuttosto che nella semplice innovazione, come invece accade. Potrebbe essere la gara più importante di tutta l’esistenza dell’umanità e pare che avremo un solo colpo in canna a nostra disposizione. La prima ASI che nascerà sarà probabilmente anche l’ultima (il che è abbastanza terrificant visto come sono buggati la maggior parte dei prodotti 1.0). D’altro canto, come sottolinea Nick Bostrom, abbiamo il grande vantaggio di poter fare la prima mossa qui ed ora. È ancora nelle nostre possibilità agire con sufficiente prudenza e lungimiranza e concederci così una forte possibilità di successo.

Abbiamo una responsabilità enorme sulle nostre spalle, da cui dipendono tutte le generazioni di vite umane a venire. Abbiamo la possibilità di essere ricordati come quelli che hanno donato la vita eterna al genere umano. O saremo i responsabili della scomparsa di questa specie incredibile, insieme alla sua musica e alla sua arte, alla sua infinità curiosità, alle sue risate. Ecco perché la sfida del nostro tempo è essere incredibilmente cauti nei confronti dell’AI. Nulla diventa più importante che ottenere questo diritto, non importa quanto tempo ci impiegheremo. È qualcosa di cui tutti oggi dovrebbero discutere, confrontarsi, impegnarsi con la massima urgenza ed attenzione.